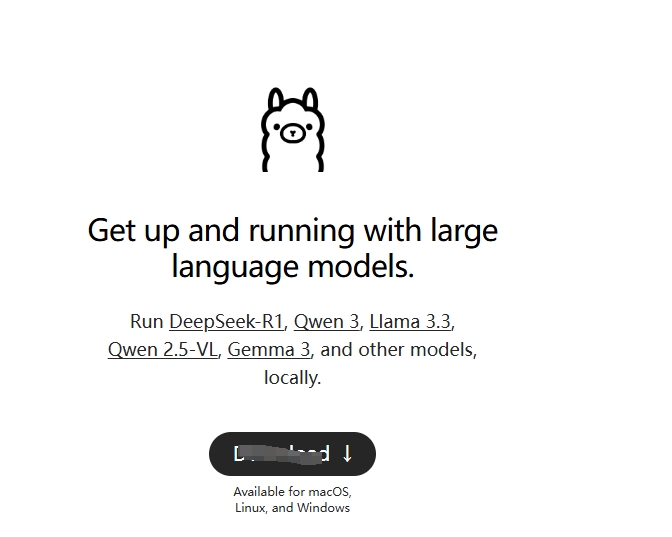

Ollama 是一个用于运行和管理大型语言模型的工具,它允许用户在本地环境中轻松地部署、使用和共享这些模型。以下是关于 Ollama 的详细介绍:

1. 核心功能

本地部署:Ollama 可以在用户的本地设备上运行,无需依赖云端服务,从而保护数据隐私。

支持多种模型:Ollama 支持多种开源语言模型,如 LLaMA、Llama2 和其他基于 Hugging Face 的模型。

简单易用:通过命令行界面(CLI),用户可以快速启动和管理模型。

高性能:利用现代硬件(如 GPU)加速推理过程,提高处理速度。

2. 安装与配置

安装:可以通过简单的命令安装 Ollama,具体步骤可以在其官方网站找到。

配置:Ollama 提供了灵活的配置选项,用户可以根据自己的需求调整模型的参数和设置。

3. 使用场景

自然语言处理:适用于文本生成、翻译、摘要等任务。

聊天机器人:可以构建个性化的聊天机器人,提供实时的交互体验。

数据分析:帮助用户理解和分析大量文本数据。

4. 社区与支持

Ollama 拥有一个活跃的社区,用户可以在论坛、GitHub 仓库和其他在线平台上获取帮助和支持。

5. 未来发展

Ollama 团队持续更新和改进工具,计划引入更多模型和支持的功能,以满足不断变化的需求。

文件1地址点击下载

客服 QQ/微信:858610021

评论0